Neben der Tokenization von Dokumenten gibt es eine Reihe weiterer sinnvoller Schritte für die Vorverarbeitung von „Big Data”. Insbesondere das Herausfiltern von Stopwords, also von Funktionswörtern wie Artikeln, Bindewörtern oder Präpositionen, die keine Bedeutungsträger sind, gehört dazu. Hinzu komm das Versehen der Wörter mit Tags, die anzeigen, um welche Wortart es sich handelt (sogenannte „Part-of-speech-Tags”), das sich POS-Tagging nennt. Obwohl dieser Vorgang alles andere als simpel ist, gibt es inzwischen zuverlässige automatisierte Systeme, die in vielen Sprachen verfügbar sind.

Darüber hinaus ist auch das Lemmatisieren der Wörter hilfreich, bei dem sie in ihre Grundform zurückgeführt werden. So verstehen Systeme schnell, dass „Haus” und „Häuser” oder „vergessen” und „vergisst” ein und dieselbe Bedeutung haben. Später verwendete Algorithmen können so lemmatisierte Texte leichter verarbeiten.

tfidf-Vektoren und die Ähnlichkeitsmatrix

Der letzte Vorverarbeitungsschritt ist die Erstellung sogenannter „tfidf-Vektoren”, die für jedes Dokument erstellt werden. So werden die Dokumente vergleichbar. Der tfidf-Vektor setzt sich aus der „Term Frequency” (tf) und der „Inverse Document Frequency” (Ida) zusammen. Sie gibt an, wie häufig jedes Wort im jeweiligen Dokument vorkommt. Wörter, die in sehr vielen Dokumenten vorkommen, sind vermutlich weniger relevant für die Bedeutung des einzelnen Texts und oftmals lediglich Funktionswörter. Die Term Frequency wird anschließend mit der Inverse Document Frequency multipliziert, die umso niedriger ist, in je mehr Dokumenten das Wort vorkommt.

Wird der tfidf-Wert für alle Wörter in allen Dokumenten ausgerechnet, so erhält man pro Dokument einen Vektor positiver Zahlen. Dieser Prozess kann ebenfalls völlig automatisch durchgeführt werden. Das Verfahren lässt vor allem Ähnlichkeiten, die im Datensatz auftreten, einfach darstellen.

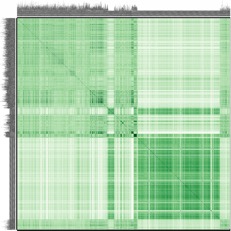

Jede Zeile und Spalte steht in der Darstellung für ein Dokument. Auf der Abbildung sind 3600 Dokumente visualisiert. Je grüner, desto ähnlicher sind die Dokumente. Die grüne Diagonale entsteht, weil die Dokumente mit sich selbst verglichen werden.

Deep Learning

Neben der Erstellung des tfidf-Vektors können Dokumente heute auch mithilfe von Deep Learning unterteilt werden. Dabei helfen Systeme, die nicht nur Zeichen und Wortarten erkennen, sondern tatsächliches Textverständnis vorweisen und satzübergreifende Referenzen, Satzbau etc. verstehen.

Selbstregulierte Aufmerksamkeit (engl. Self-Attention) ermöglicht „neuronalen” Netzen Zusammenhänge zwischen Wörtern zu erschließen, wie z.B. Negationen oder den Bezug eines Personalpronomens. Dazu zählt u.a. BERT (Bidirectional Encoder Representations from Transformers), eine von Google entwickelte Transformer-Architektur.

Darin werden einzelne Wörter durch sogenannte Word Embeddings repräsentiert. Das neuronale Netz kreiert aus dieser Wortsequenz des Kontexts eine neue abstrahierte Version des Dokuments. Diese Deep Learning Architektur ist mittlerweile auch auf Deutsch erhältlich.

Lesen Sie nächste Woche mehr zu diesem Thema in Teil 3 des Artikels „Case Study: Big Data in Krisenunternehmen“!